热门标签

热门文章

- 1解决UnicodeDecodeError: ‘utf-8‘ codec can‘t decode byte 0xce in position 130: invalid continuation byt_invalid continuation byte

- 2python基本概念——标识符_数据库中my_name是正确的标识符吗

- 3初识flash芯片----写之前为什么要先擦除_flash擦除原理

- 4黑客必备的操作系统——kali linux安装_kelly linux

- 5阿里Java面经大全(整合版)

- 63DGS 其二:Street Gaussians for Modeling Dynamic Urban Scenes

- 7Kafka详解(四)多线程消费者实践_kafka 多线程

- 8B站小甲鱼python学习笔记_b站extend函数

- 9隐私安全保护:用技术守护个人信息的安全_网络技术进步也为隐私保护提供了新的手段

- 10echarts中树节点样式的修改方法_echarts树状图调整根节点样式

当前位置: article > 正文

探索和构建 LLaMA 3 架构:深入探讨组件、编码和推理技术(五)RMS 均方根归一化

作者:小小林熬夜学编程 | 2024-04-27 18:40:31

赞

踩

探索和构建 LLaMA 3 架构:深入探讨组件、编码和推理技术(五)RMS 均方根归一化

探索和构建 LLaMA 3 架构:深入探讨组件、编码和推理技术(五)RMS 均方根归一化

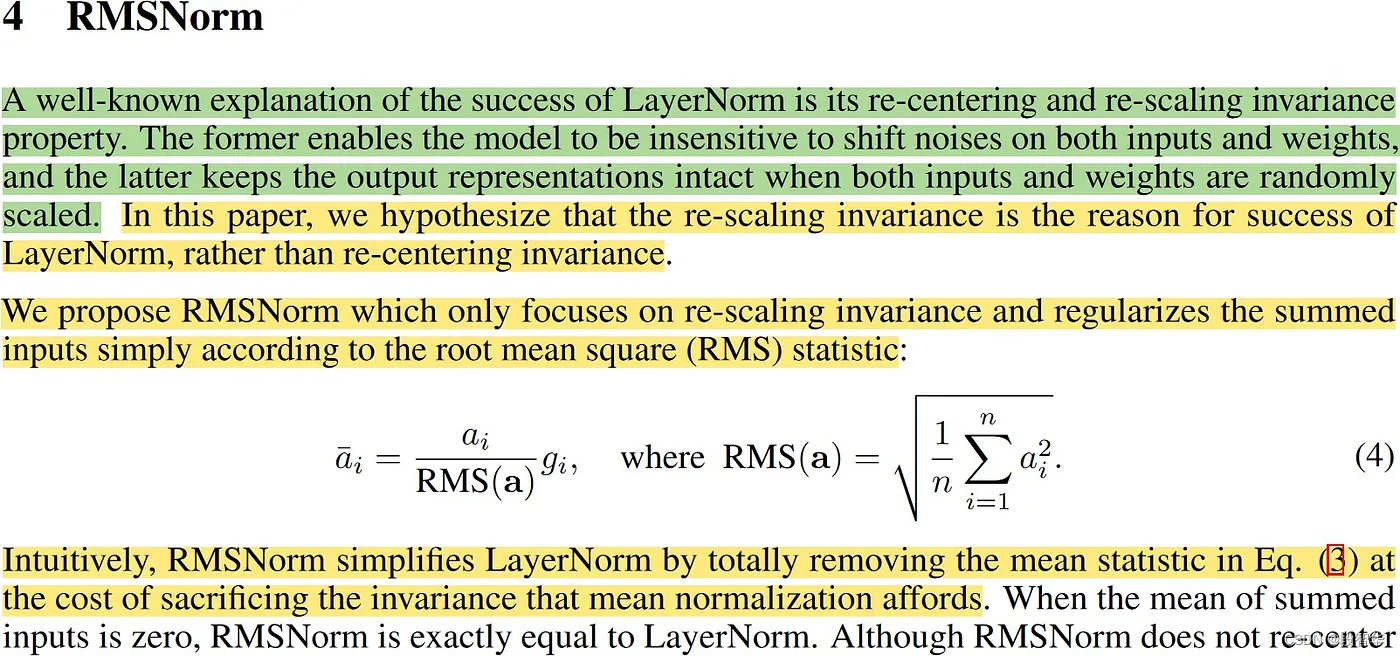

RMS(均方根归一化)

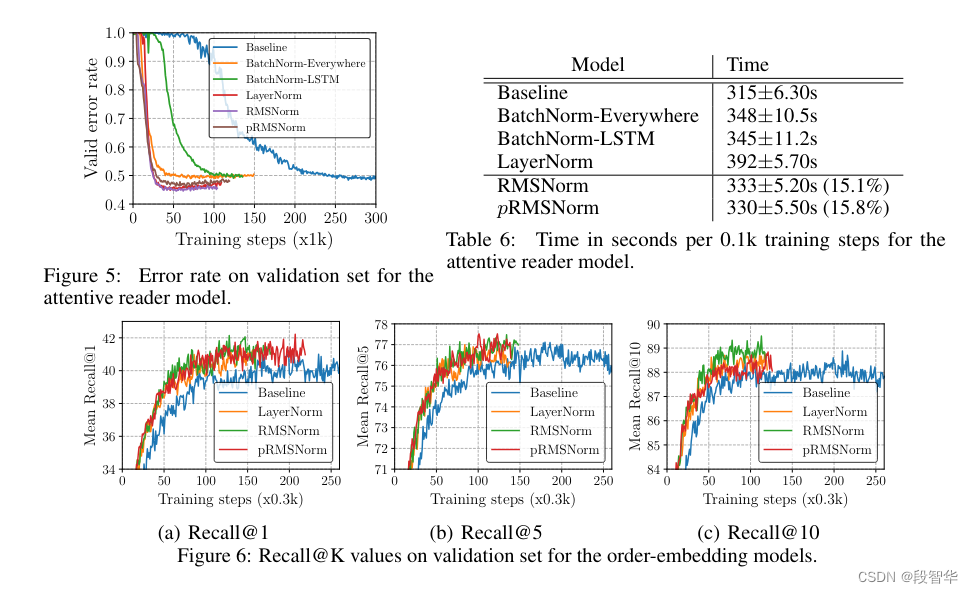

均方根归一化(RMSNorm)是一种相对新颖的归一化技术,由 Biao Zhu、Rico Sennrich 在 2019 年提出。与 BN 和 LN 不同,RMSNorm 基于激活本身的均方根对激活进行归一化,而不是使用小批量或层统计数据。这种方法可确保无论小批量大小或特征数量如何,激活的缩放都是一致的。此外,RMSNorm 引入了可学习的尺度参数,提供与批量归一化类似的适应性。

像层归一化一样, 也有一个可学习的参数gamma(左侧公式中的g ),它乘以归一化值。

class RMSNorm(nn.Module):

def __init__(self, dim: int, eps: float = 1e-5):

super().__init__()

self.eps = eps

# The gamma parameter

self.weight = nn.Parameter(torch.ones(dim))

def _norm(self, x: torch.Tensor):

# (B, seq_len, dim) -> (B, seq_len, 1)

return x * torch.rsqrt(x.pow(2).mean(-1, keepdim=True) + self.eps)

def forward(self, x: torch.Tensor):

# dim : (B, seq_len, dim) -> (B, seq_len, dim)

return self.weight * self._norm(x.float()).type_as(x)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

系列博客

探索和构建 LLaMA 3 架构:深入探讨组件、编码和推理技术(一)

https://duanzhihua.blog.csdn.net/article/details/138208650

探索和构建 LLaMA 3 架构:深入探讨组件、编码和推理技术(二)

https://duanzhihua.blog.csdn.net/article/details/138212328

探索和构建 LLaMA 3 架构:深入探讨组件、编码和推理技术(三)KV缓存

https://duanzhihua.blog.csdn.net/article/details/138213306

探索和构建 LLaMA 3 架构:深入探讨组件、编码和推理技术(四)分组多查询注意力

https://duanzhihua.blog.csdn.net/article/details/138216050

本文内容由网友自发贡献,转载请注明出处:【wpsshop博客】

推荐阅读

相关标签