热门标签

当前位置: article > 正文

支持英特尔独立显卡的OpenVINOTM 2022.2新版本来啦_openvino支持哪些显卡

作者:我家小花儿 | 2024-05-28 19:10:30

赞

踩

openvino支持哪些显卡

前言

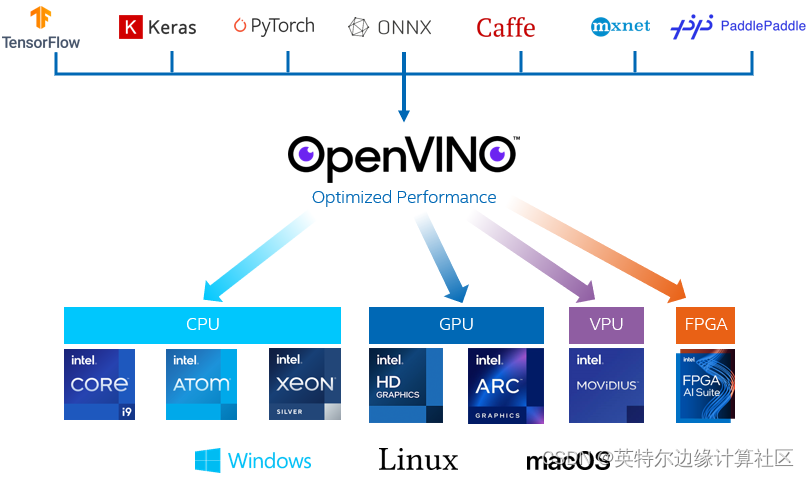

金秋已至。伴着凉爽的秋风一起到来的,还有OpenVINO™工具套件刚刚推出的最新版本OpenVINO™2022.2。除了能支持英特尔今年新推出的一系列独立显卡进行AI模型的推理加速及部署外,2022.2的新版本中还有哪些亮眼的新特性呢?让我们一起来看看吧。

- 更广泛的模型和硬件支持 – 新增包括英特尔独立显卡等的硬件支持,并减少动态输入时的内存消耗、提升NLP应用效率。

- 更好的性能及可移植性- 通过跨 CPU、GPU 等的自动设备发现(automatic device discovery)功能、负载平衡和动态推理并行,立即提高性能。

- 更多的集成- 与深度学习框架实现更好的集成,以最少的代码更改,更好地与框架保持一致。

下面让我们一起来详细了解一下这些主要的新特性。

1.更广泛的模型和硬件支持

OpenVINO™2022.2新版本提供了更广法的模型和硬件支持,包括:

- 新增:支持英特尔®第13代台式机酷睿处理器(代号为Raptor Lake)。

- 新增:支持用于深度学习及推理工作负载的英特尔独立显卡,包括英特尔®数据中心GPU Flex 系列和英特尔®Arc,可用于智能云、边缘和媒体分析的工作负载。

- 新增:支持对英特尔®第4代至强®可扩展处理器(代号为Sapphire Rapids)的预览支持,测试您的模型性能。

- 优化减少动态输入时CPU的内存消耗,从而更高效支持自然语言处理(NLP)的应用。

2.更好的性能及可移植性

通过跨CPU、GPU等的自动设备发现、负载平衡和动态推理并行性,立即看到性能提升。

- 新增:在 AUTO 功能中引入新的性能倾向选择“Cumulative throughput”,使多个加速器(例如多个GPU)可被添加到AUTO的自动发现、配置的基本功能中,能够被同时使用,以最大限度地提高推理性能。

- 推出Intel®FPGA AI Suite,在这个易于使用的软件包中实现实时、低延迟和低功耗的深度学习推理。

3.更多的集成

面向尚未安装本机OpenVINO™工具套件的用户,提供了更多的与深度学习框架的集成,使得开发者使用和维护代码更加简单方便,同时保持更新时需要修改的代码最少。

- 最近更新的OpenVINO Execution Provider for ONNX Runtime通过轻松添加OpenVINO,为ONNX运行时开发人员提供了更多性能优化选择。

- 新增:通过OpenVINO™ 与PyTorch ONNX Runtime的融合(OpenVINO ™ Torch-ORT),加速PyTorch模型推理。现在,PyTorch开发人员可以更无缝地与OpenVINO集成,并通过更少的代码更改获得性能提升。

- OpenVINO与TensorFlow的集成现在支持更深入的学习模型和改进的推理性能。

以上就是OpenVINO™2022.2新版本的主要新特性介绍,除此之外,新版本中还增加了一些新的算子的支持,增加了对集成显卡的优化等等,详细的介绍可以进入以下网页进行浏览和了解:Documentation — OpenVINO™ documentation

最后,当然还是提醒大家,OpenVINO™2022.2版本可以在此处下载Download Intel® Distribution of OpenVINO™ Toolkit ,并已在以下分发渠道上提供:

欢迎大家下载安装使用。

大家还可以给我们留言对哪些特性感兴趣,后续将根据大家的留言,继续有针对性地展开更为详细的介绍。快来给我们留言吧!

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/我家小花儿/article/detail/638900

推荐阅读

相关标签