热门标签

热门文章

- 1Python JWT 介绍

- 2小程序引入字体注意点_微信小程序端字体链接必须是同源下的,或开启了cors支持,微信小程序的域名是servic

- 3用Three.js打造酷炫3D个人网站(含源码)_three.js案例网站

- 4Verilog--除法器的简单实现_verilog除法

- 5MathType2024最新7.6汉化破解版下载_mathtype 7.6

- 6windows远程访问树莓派ubuntu22.04 桌面 - NoMachine

- 7PyTorch2.0 环境搭建详细步骤(Nvidia显卡)_nvida pytorch

- 8webUI自动化之基本框架搭建(python + selenium + unittest)_python ui自动框架

- 9Android 使用retrofit+kotlin协程,搭建MVVM框架_android retrofit kotlin

- 10MySQL中的全表扫描和索引树扫描_mysql 全表扫描

当前位置: article > 正文

wordcloud制作词云图_wordcloud支持把词云生成png格式图片

作者:我家自动化 | 2024-04-29 07:15:57

赞

踩

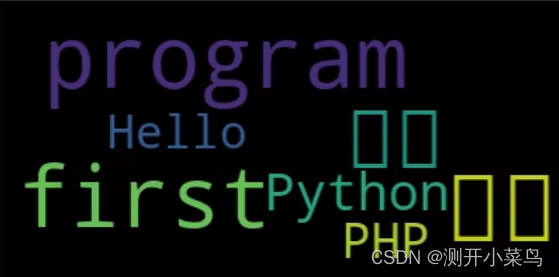

wordcloud支持把词云生成png格式图片

wordcloud制作词云图

wordcloud

WordCloud(font_path=None, width=400, height-200,margin=2,mask=None, max_words=200, min_font_size=4, stopwords=None,background_color='black', max_font_size=None, font_step=1)

- 1

- font_path:字体路径,默认不支持中文,可通过该参数指定字体,支持OTF和TTF 格式;

- width、 height:画布的宽度和高度,单位为像素

- margin:文字之间的边距

- mask:指定图片的形状,忽略白色部分,通常为 ndarray

- max_words:最多显示的词的数量,默认为200

- min_font_size、max_font_size:最小字体大小、最大字体大小

- font_step:字体大小增加步长,默认为1

- background_color:词云图的背景颜色,默认为黑色

- generate (text):根据文本生成词云图,返回当前对象本身;

- to_image():将词云对象转化为图片

- to_file(文件名):将词云对象转化为文件

- to_array():将词云对象转化为数组

import wordcloud as wc

import random

word_cloud = wc.WordCloud()

res = random.choices(["Python","Hello","中国","人民","World","program","first","PHP"], k=100)

text = " ".join(res)

print(text)

word_cloud.generate(text)

word_cloud.to_file("abab.png")

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

中文方框问题

当字符串中有中文时,生成的词云图会变成方框。

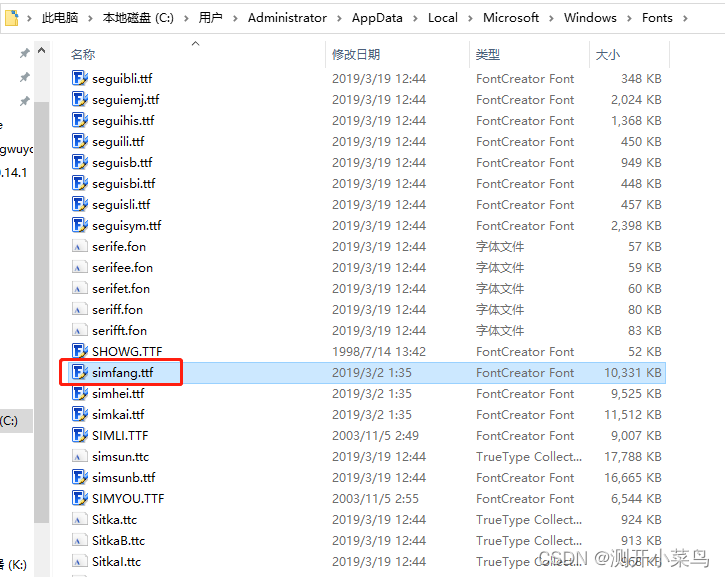

这是因为不支持中文,我们需要添加字体文件。我们可以去c盘中(C:\Users\Administrator\AppData\Local\Microsoft\Windows\Fonts)复制一个字体文件放在python目录(D:\code\python\python37\libs)中。

然后在代码中指定font路径。

word_cloud = WordCloud(font_path=r'D:\code\python\python37\libs\simfang.ttf')

- 1

显示图片

import matplotlib.pyplot as plt

# 显示词云图

plt.imshow(word_cloud)

plt.show()

- 1

- 2

- 3

- 4

jieba(分词)

jieba库分词的三种模式

(1) 精准模式:把文本精准地分开,不存在冗余

(2) 全模式:把文中所有可能的词语都扫描出来,存在元余(2)

(3) 搜索引擎模式:在精准模式的基础上,再次对长词进行切分

jieba.cut(sentence, cut_all=False, HMM=True):sentence表示需要分词的句子,cut_all表示是否采用全模式,HMM 表示是否使用 HMM ( 隐马尔可夫模型 )模型jieba.cut_for_search(sentence, HMM=True):sentence表示需要分词的句子,HMM表示是否使用 HMM模型,该方法适合用于搜索引擎构建倒排索引的分词,粒度比较细;jieba.cut()方法和jieba.cut_for_search()方法返回的结果都是可迭代对象,可使用 for 循环获取分词后得到的每一个词语,此外,jieba.lcut()和jieba.lcut_for_search()效果分别和jieba.cut()和jieba.cut_for_search()效果类似,直接返回列表add_word(word, freq=None, tag=None)和del_word(word)可在程序中动态修改词典

import jieba from PIL import Image import numpy as np import matplotlib.pyplot as plt from wordcloud import WordCloud # 读取图片 mask = np.array(Image.open("ciyun1.png")) # 创建词云 words = WordCloud(font_path="msyh.ttc",mask=mask,background_color="black",width=1000,height=700,min_font_size=6) with open("text.txt","r+",encoding="utf-8") as fp: text = fp.read() # 读取文件内容 text = " ".join(jieba.lcut(text))#通过空格连接分好的词 words.generate(text) # 生成词云 words.to_file('abc.png') # 保存词云图 plt.imshow(words) # 显示图片 plt.axis("off")#不显示坐标轴 plt.show()# #显示图

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/我家自动化/article/detail/506541

推荐阅读

相关标签