- 1黑马 - websocket搭建在线聊天室

- 2YOLO系列算法全家桶——YOLOv1-YOLOv9详细介绍 !!

- 3解决WPF ListView虚拟化ListViewItem的IsSelected属性MVVM双向绑定bool值后出现的绑定错乱的问题_listviewitem 绑定

- 4海康威视isecure center 综合安防管理平台文件上传漏洞复现_综合安防漏洞

- 5json_encode() 中文乱码问题解决方法_json_encode中文

- 6GLM-4多模态重磅更新!摸着OpenAI过河!_glm 智能体

- 7我发现凡是给offer的公司,面试时基本不问技术细节,那些问得又多又细的公司,后面就没下文了!...

- 8全网最详细的MySQL笔记(一)_mysql的newtable

- 9雷达人体存在感应器成品,雷达探测感知联动,空间智能化控制应用

- 10通过Dronekit实现pixhawk2.4.8与树莓派4B通信

Kimi:作为一款超长文本AI工具,我是怎么用它来卷论文的?_为什么kimi chat不能翻译整篇英文文献

赞

踩

我是娜姐 @迪娜学姐 ,一个SCI医学期刊编辑,探索用AI工具提效论文写作和发表。

Kimi作为一款国产AI工具,最近很火。起因是它的200万字超长上下文开始开放内测了。不过也要吐槽一下,自从Kimi火了之后,服务器超负荷了,动不动就“Kimi累了”来个罢工。内测开放也遥遥无期,不知道啥时候能排上。

Kimi正式上线的时间是2023年10月,这个国产的AI大模型背后的公司叫月之暗面(Moonshot AI),公司的创始人,90后的杨植麟和核心团队成员参与了Google Gemini、Google Bard、盘古NLP等多个大模型的开发,可以说阵容还是很强大的。

Kimi上线之时,最突出的亮点就是支持无损上下文20万汉字。2024年3月,Kimi宣称已经将上下文扩展到200万汉字。按照AI领域的计算标准,200万汉字的长度大约为266万token。对比全球知名大模型,长文本能力最强的谷歌gemini 1.5、Claude 3支持100万token,kimi 200万汉字上下文长度或已超越海外顶尖大模型水平。

为啥上下文长度这么重要?

因为一篇学术论文至少是3-5000字,更多的上下文就意味着更强大的分析理解能力。不论是阅读还是润色,完整的阅读整篇论文和只给一个片段,输出质量是截然不同的。比如ChatGPT,虽然有时候可以用“继续”来让它输出更多,但是“继续”多了它就会胡说八道,跑题了。所以鱼一样的记忆,啥事也干不了。

言归正传,Kimi的20万字上下文,在学术论文的阅读写作中,能怎么用呢?娜姐总结了以下5点:

1 文章内容总结分析,及长文翻译:

对于开源的OA期刊,我们可以直接提供网址,让Kimi快速帮我们解读论文精华:

长文翻译功能:

我给Kimi一篇6000字左右的论文全文,请它翻译成中文。中间“继续”了4次,它最终完整的翻译了全文,没有开小差。译文10232个字,加上原文,上下文一共1.6w字,还是很强大的。

说明一下,如果你直接上传pdf,翻译效果没有将文字粘贴在对话框效果好。我猜是pdf中的排版格式阻碍了Kimi对文章的读取。

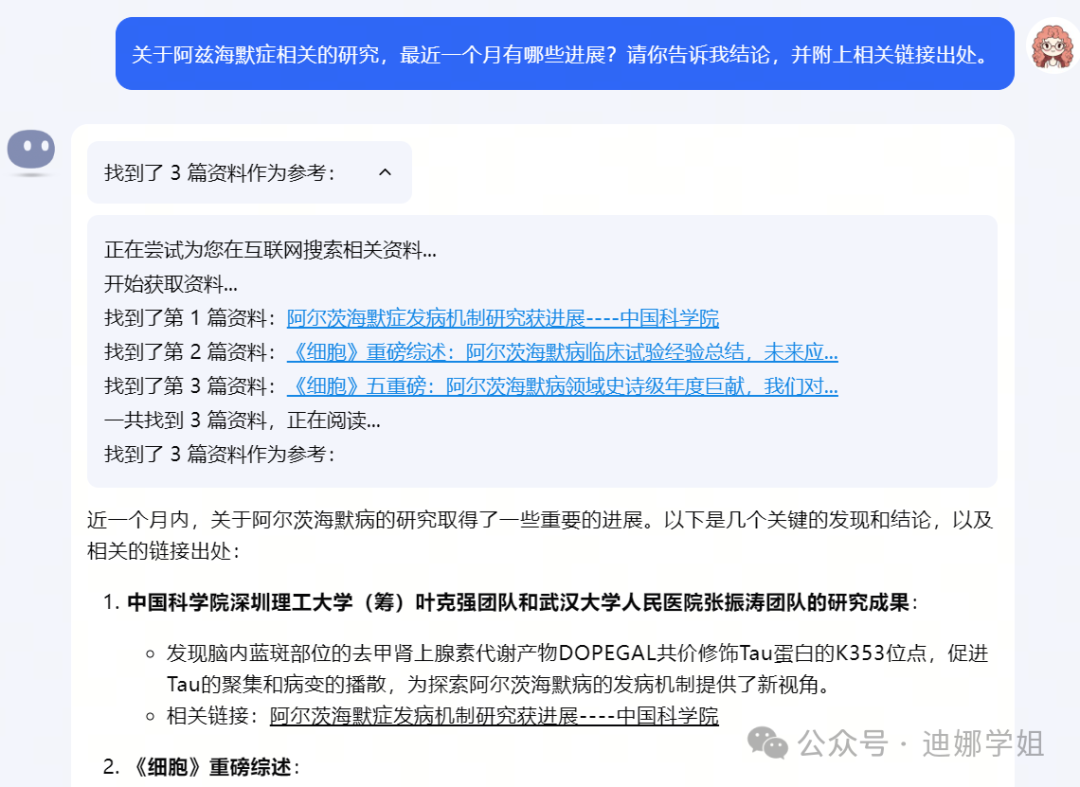

2 提供联网搜索结果:

有时候我们想要知道某领域的最新进展,或者消息的出处,像ChatGPT这样的大模型,虽然后来有了联网功能或是Webpilot这样专门有联网功能的GPTs,但是网络搜索功能仍然不尽如人意。

我们来看看Kimi的表现如何:

如果我们用中文提问,Kimi会给出中文世界的出处,并附上链接:

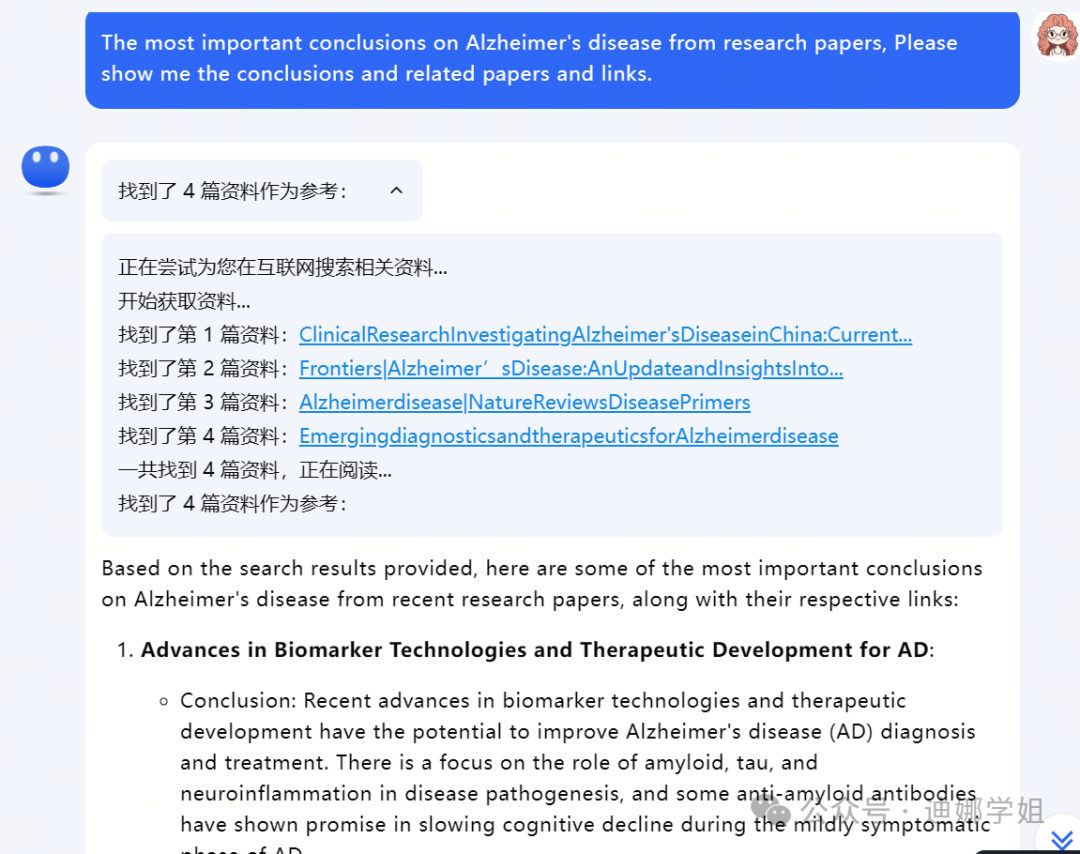

如果我们想知道相关文献,可以用英文问:

最重要的是,Kimi会理解我的问题,从联网搜索到的资料中,提取相关答案,给出“关于AD最重要的结论和相关论文”,可以说理解力很不错。

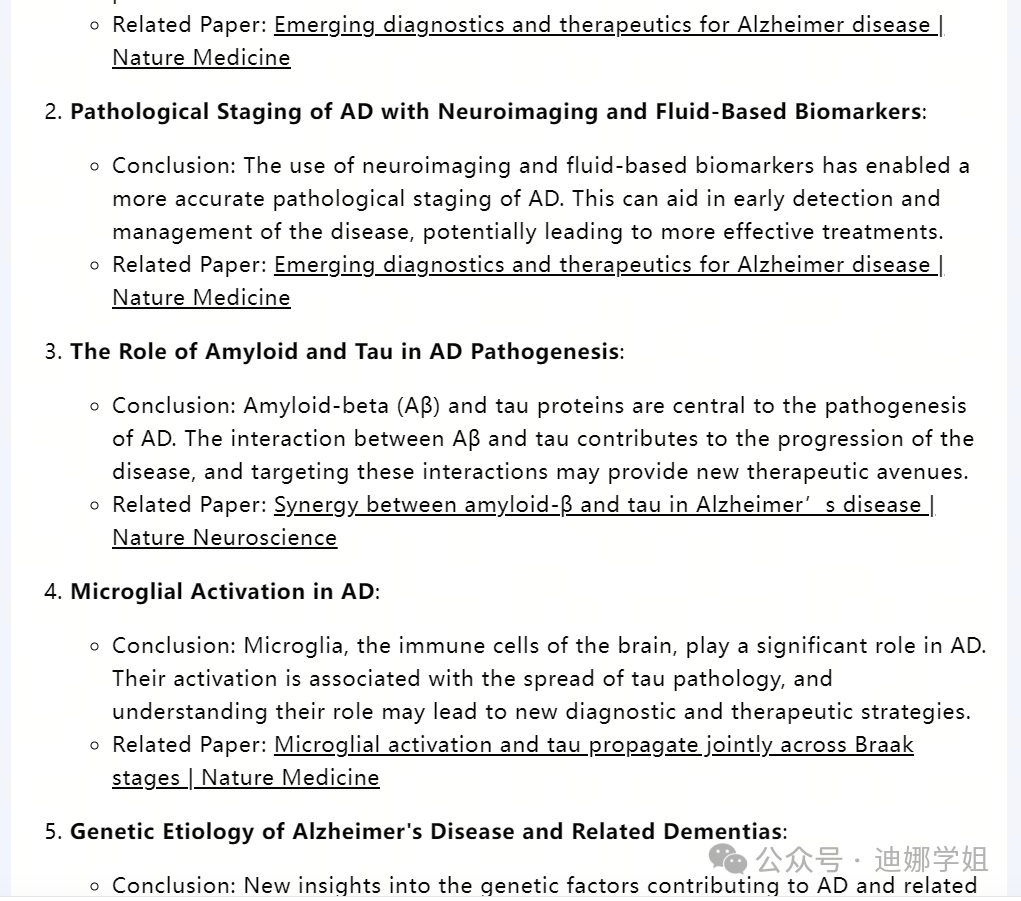

3 多篇论文的分析总结,快速全面了解一个新领域:

对于某一个领域,我们想要快速了解全球学者都在做哪些方向,取得了那些进展。我们可以借助Kimi来快速总结。

上传几篇近3-5年的高质量综述,请Kimi总结分析:

Kimi一下子给我们提供了8个主流的研究方向,如果我们对某一个研究方向感兴趣,想知道更多,可以继续追问。

4 辅助实验设计,快速推进实验进展:

看了某几篇文献,深受启发,想要设计一个类似的实验,可以把你的标题和意图告诉Kimi,请它帮你设计实验。Kimi会告诉你每一个实验设计的目的、所用材料和仪器,甚至注意事项都特别专业。你照着清单准备就行。

5 辅助撰写论文:

借助它的超长上下文理解,在写毕业论文或者期刊论文的时候,我们可以提供给Kimi我们的实验设计和主要结果,让它帮我们撰写讨论部分。

以下是它的输出结果:

第一段是引言,最后一段是总结,中间的四段分别讨论了4个相关的实验结果。连参考文献都给列出来了。作为一个初稿,我觉得完成度至少有70%。

总结一下,Kimi在学术论文阅读写作中,用处还是很多的。包括长文分析总结、翻译,联网信息实时检索、多篇论文总结归纳、实验设计、论文撰写等方面。

就是最近太火,服务能力没跟上,动不动就罢工。希望公司不要在营销了,赶快解决一下超载问题。

也有人说,Kimi就是营销玩得好,其实名不副实,大模型并没有那么厉害。就娜姐使用下来的体验,国产模型里面,Kimi算是很好用的。另一方面,也反映了群众对于超长文本容纳能力的需求,放眼国内外AI大模型,就Claude 3能与之抗衡,特别是Claude 3 Opus版本,长文本输入和输出,效果非常好,理解能力也很强大。但是,能不能用的上,就各凭本事了。

往期干货精选:

ChatGPT助力论文写作:

-

SCI论文写作与发表: