- 1华为OD机试 - 最小调整顺序次数、特异性双端队列(Java & JS & Python)_最小调整次数

- 2【Elasticsearch 未授权访问漏洞复现】_elasticsearch未授权访问漏洞复现

- 3小米开源便签Notes-源码研究(1)-导出功能整体思路

- 4从零开始配深度学习服务器2023.04.01_从零开始配一个深度学习服务器

- 5欧科云链研究院:如何降低Web3风险,提升虚拟资产创新的安全合规

- 6TCP 和 UDP的区别

- 7基于chatgpt-on-wechat的微信个人对话机器人搭建

- 8python、C# 写企业微信机器人推送【图文消息】_python 企业微信机器人推送图文

- 9Python 分治法求最大最小元

- 10某城商银行生产容器云平台详细设计方案分享及经验总结_银行容器云平台项目计划书

LLama 2部署教程+私有模型分发_llama2本地部署

赞

踩

近日,Meta发布了LLama的最新版本——LLama2,尽管其对中文的处理能力尚有待提升,但其整体表现无疑是令人瞩目的。在发布当天,我便迫切地将其下载下来进行试用,发现相比之前的版本,LLama2在多个方面都实现了显著的进步,特别是在编程能力上的提升更为显著。在此,我与诸位分享一下如何在Linux环境下部署LLama2模型,以及如何将该模型如何利用YourChat在团队中进行共享。

一、下载注册模型

首先,我们需要访问此网址https://ai.meta.com/resources/models-and-libraries/llama-downloads/,并提供一些基本信息。所需填写的信息包括姓名、电子邮箱、国家和公司等,按照真实情况填写即可。尽管审核过程并不严格,但考虑到某些特殊因素,建议在国家一栏选择美国。

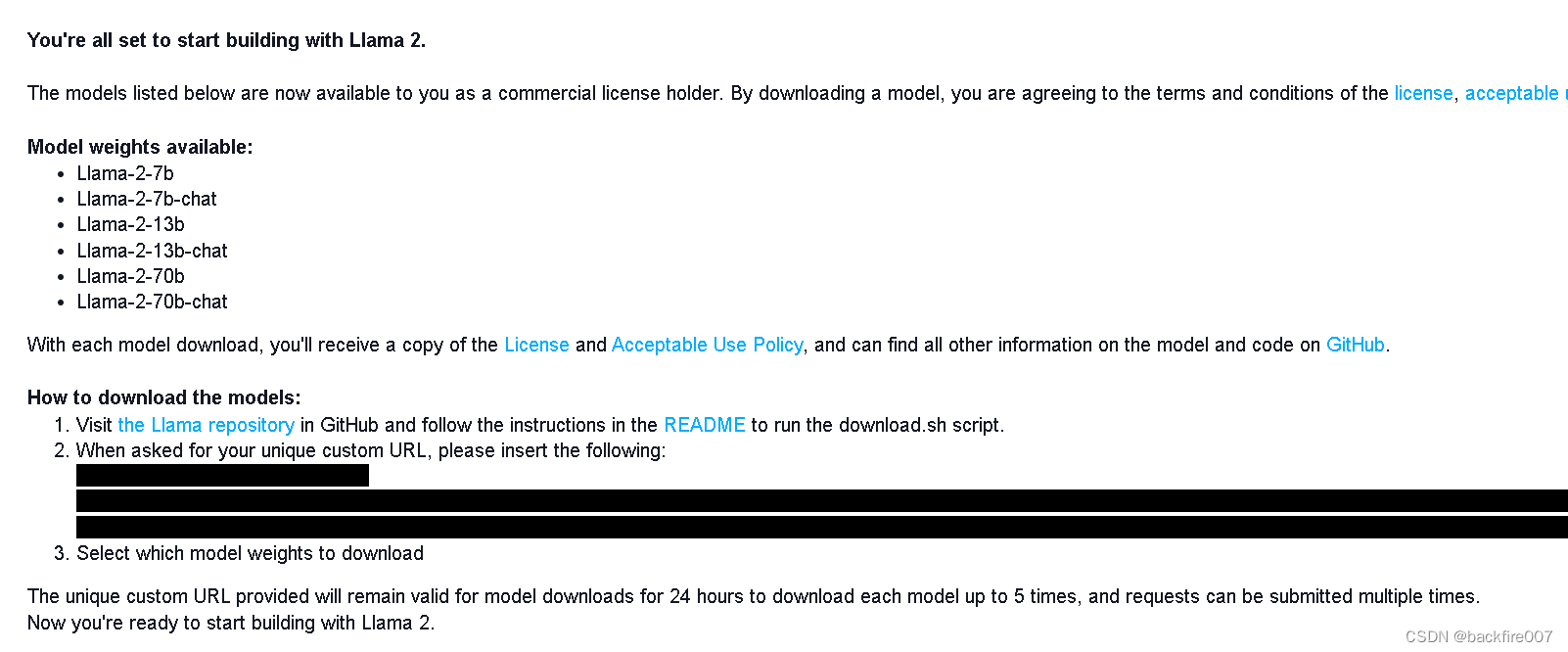

注册完毕后,可能需要等待一段时间。我本人等待了大约一个小时后,收到了Meta发来的邮件。邮件如下:

邮件中会附带一个key,也就是图片中涂黑的部分。大概格式是一个网址,但是访问这个网址是没有用的,要把这个key复制下来,因为我们后续会用到它。

二、下载LLama 2

截至目前,LLama2已推出了7B、13B、70B、7B-chat、13B-chat、70B-chat这六种模型,并为聊天功能推出了chat版本。值得一提的是,chat版本采用了RLHF进行了微调,这在当前的大语言模型中无疑是非常前沿的。此外,30B版本也将很快推出。

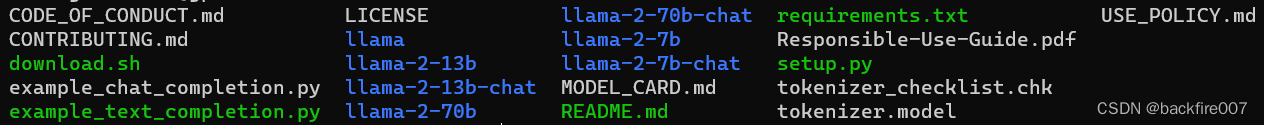

我们接下来将通过官方的脚本下载模型。首先,我们需要访问LLama的官方GitHub仓库https://github.com/facebookresearch/llama,并克隆该项目库。完成克隆后,在项目库中找到并运行download.sh脚本,然后按照提示输入你之前复制的key,并选择你需要的模型,就可以开始下载了。下载服务由Meta自家提供,下载速度非常快,我当时是满速下载完成的。

我当时选择了下载所有的模型,以下是我下载完成后的文件列表。

以llama-2开头的文件夹即为刚刚下载的模型