- 1同样的APP为何在Android 8以后网络感觉变卡?

- 2史上最全!用Pandas读取CSV,看这篇就够了

- 3基础编码管理组件 Example 程序

- 4【实用党】推荐几款实用的AI工具_手绘生成图片

- 5【C语言篇】链表的基本操作-创建链表、插入节点、删除节点、打印链表_链表结构体打印链表程序

- 6【行为识别现状调研1】_多尺度时空特征和运动特征的异常行为识别

- 7QUIC:基于UDP的多路复用安全传输(部分翻译)_quic的多路复用

- 8mysql查询和修改的底层原理_数据库修改的实质是什么

- 9技术的正宗与野路子 c#, AOP动态代理实现动态权限控制(一) 探索基于.NET下实现一句话木马之asmx篇 asp.net core 系列 9 环境(Development、Staging ...

- 10中兴新支点桌面操作系统——一些小而美的功能

产品经理的AI秘籍:从AIGC到大模型,让你笑傲智能时代

赞

踩

前言

随着人工智能技术的飞速发展,AI理论已经成为科技领域的重要组成部分。本文将以AI理论科普为主题,向大家介绍AIGC、大模型、预训练模型的训练过程,以及幻觉和涌现等概念。通过本文的介绍,希望对AI感兴趣的小伙伴能够对AI理论有更深入的了解,并认识到人工智能技术在我们生活中的重要作用。

一、什么是AIGC?

我们发现市面上有很多生成文本,代码,图片,音频,视频等等的AI工具,那么将这些AI生成的内容被叫做AIGC。即AI Generated

Content, AI生成内容 像ChatGPT生成的文章,GitHub Copilot生成的代码(是由 GitHub 和 OpenAI

联合开发的一款 AI

编程助手),Midjourney生成的图片等等都属于AIGC。

国内流行说AIGC,国外流行说Generative AI,即生成式AI 从二者关系上也很好理解:生成式AI,生成的内容就是AIGC

二、什么是大模型

具有海量参数和复杂结构的机器学习模型。这些模型通常在训练过程中需要大量的数据和计算能力,其设计的目的是为了提高模型的表示能力和性能,在处理复杂任务时能够更好地捕捉数据中的模式和规律。

2.1 大模型特点

参数量庞大:大模型一般具有数亿到数千亿个参数不等。

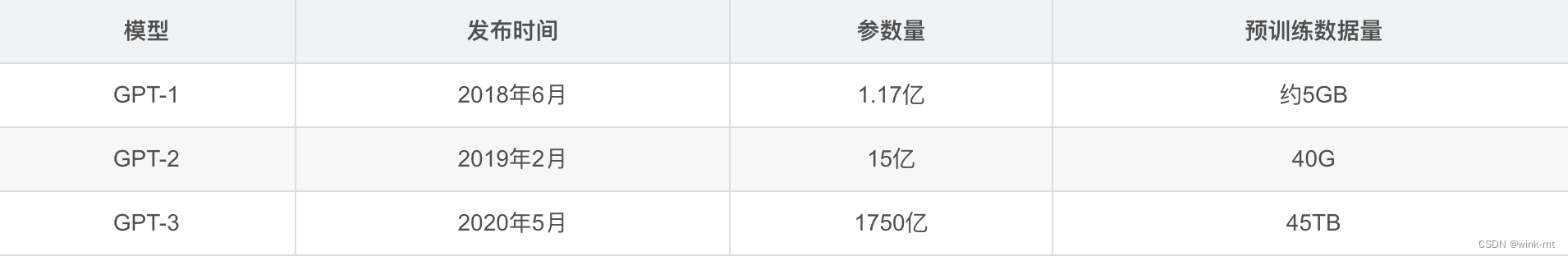

全网海量数据,以GPT-3为例,截止2023年4月的训练时间,公开的信息是,GPT3有多个不同的版本,参数范围从13亿到1750亿不等。最大的版本GPT-3.5有大约1750亿个参数。

层级结构深:由于大模型需要能够处理储量的参数,因此模型结构应该具有良好的可扩展性,能够容纳更多的层和单元,这有助于提高模型的表达能力和性能。

2.2 大模型里程碑——Transformer的发布

在2017年Google的研究团队在2017年发表的论文《Attention Is All You Need》首次提到Transformer。其背景主要是在于当时自然语言处理(NLP)领域对于更高效、更强大的模型的需求。在这篇论文发表之前,大多数序列转导模型(例如,用于机器翻译的模型)都依赖于循环神经网络(RNNs)或卷积神经网络(CNNs),这些模型在处理长距离依赖时存在一定的局限性,并且计算效率不高。Transformer的提出不仅在技术上带来了创新,也在多个领域产生了深远的影响,成为了现代人工智能和深度学习的一个重要里程碑。

2.2.1 Transformer通俗解释

2.2.2 基于Transformer的扩展诞生Google的BERT模型和OpenAI的GPT模型

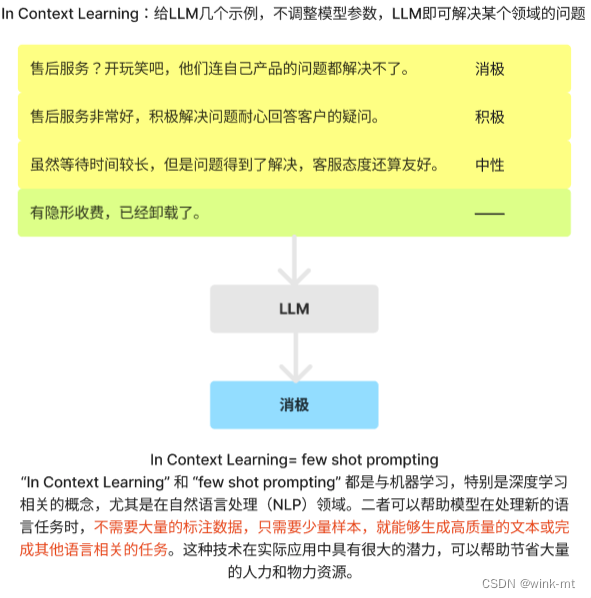

这篇论文发布之后,人工智能迎来了一波新的春天,bert再17–20年还是比较火的,但是研究人员发现在训练加微调的bert并不是NLP领域的一个最优的选择,因为bert有一个缺陷,就是在针对具体的一些下游任务的时候,它需要做一定的微调,那么微调就需要有大量的标注数据,而大量的标注数据就意味着大量的人工去处理里面的一些工作,那么在资源上就有损耗了。

所以有些研究人员就在探索,我们是否可以在少量标注数据的情况下去获得更好的性能,以OpenAI公司为代表的GPT就做到了,在扩大语言模型的参数会显著的提高对零样本或者小样本的一个学习能力,这个现象特别是在GPT3的时候尤为显著,当GP3的投入训练达到了1750亿参数之后,我们用少量的一个样本就可以让这个模型学会更多的新技能,而且这些技能又可以追评甚至超过一些bert在一些垂类的专供模型,那么其实这就引发了一个学术界的狂潮,也意味着生成式预训练的一个大模型当它的参数量大到一定程度的时候就可以产生新的技能叫做顿悟或者现在也把它叫做涌现。

那么这种新能力的涌现很可能就是通向通用人工智能API的第一步,因此到了2020年时以GPT为首的大模型就开始盛行。

2.3 为什么大模型到2020年才开始兴起?

那么既然大模型效果这么好这么有用,为什么到了2020年的时候才开始兴起呢?总结下来主要有3个原因。

1.大数据的发展 :互联网的快速发展积累了大量的数据,这些数据为大模型的训练提供了丰富的原料。

2.存储成本的降低:GPT3大概有45TB,1981年,1个5MB的硬盘驱动可能需要大约1000美元,到了80年代末,硬盘驱动量增加到了几百MB,但价格依然很高。到了2023年云存储1TB/天,不超过1美元。所以存储成本的降低也是降低了训练大模型的代价。

3.GPU的发展:随着GPU和TPU1等专用硬件的发展,以及云计算资源的普及,研究人员和公司能够训练更大规模的模型,也大大降低了时间成本。

2.4 预训练模型是什么?

当你具备某个领域的经验时,可以将这种经验迁移到其他相似的领域上,这就是迁移学习。 预训练模型就很好地利用了迁移学习这一特点,它先学习知识,此时没有给它安排任何具体的任务。一旦基础知识掌握扎实,当有具体任务需要完成时,就针对任务的特点进行微调。

比方,可以想象成一个已经上过很多年学、阅读过大量书籍的学生。这个学生在学习过程中已经吸收了大量的知识,形成了一套自己的世界观和理解事物的框架。现在,如果你给这个学生一个新的问题,比如问他对某个新闻事件的看法,他可以利用之前学到的知识快速给出一个有深度的分析和见解。

三、 预训练模型是如何训练的?

3.1预训练模型学的是什么?

对语义、结构和关系的理解——>下一个字出现的概率。

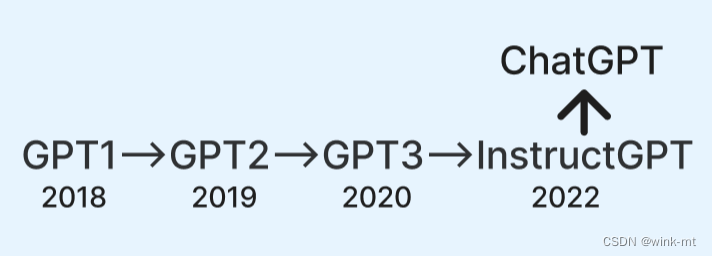

3.2GPT的构建之旅

> InstructGPT比GPT3有哪些方面的改进?

- InstructGPT使用的训练数据,是人们更加经常使用到的,比如:日常的对话,常见的数学、物理知识等等。因此我们使用ChatGPT才能更像对话。

- 引入了强化学习 ChatGPT这次能破圈引起全球讨论,原因是采用了对话形式,让每个普通人都能感受到人工智能技术的

ChatGPT的出现并不是说OpenAI有多厉害,他们用的技术并不都是原创的技术,甚至很多模型都是行业内开源的,但是他们巧妙地把这些模型融合到了一起。更为关键的是,ChatGPT将模型参数扩大到了1750亿,模型框架没有改变,但是参数有了十倍、百倍的增长,最终量变引发了质变。

3.3监督学习

监督学习:给数据集的特征先打标签,对机器接收到新的输入特征后能准确的预测出相应的输出值。

3.4无监督学习

将没有打标签的数据源给机器,告诉机器把这些数据特征分进行分类。

3.5强化学习

强化学习(Reinforcement Learning,简称RL)是机器学习的一种方法,

主要研究智能体(agent)如何在环境中采取行动以实现特定目标。

强化学习的目标:智能体通过与环境互动来学习最佳策略或行为模式。 这种学习方式不需要显式的指导或标记的训练数据,而是通过尝试和错误来不断调整行为策略,以最大化累积奖励。

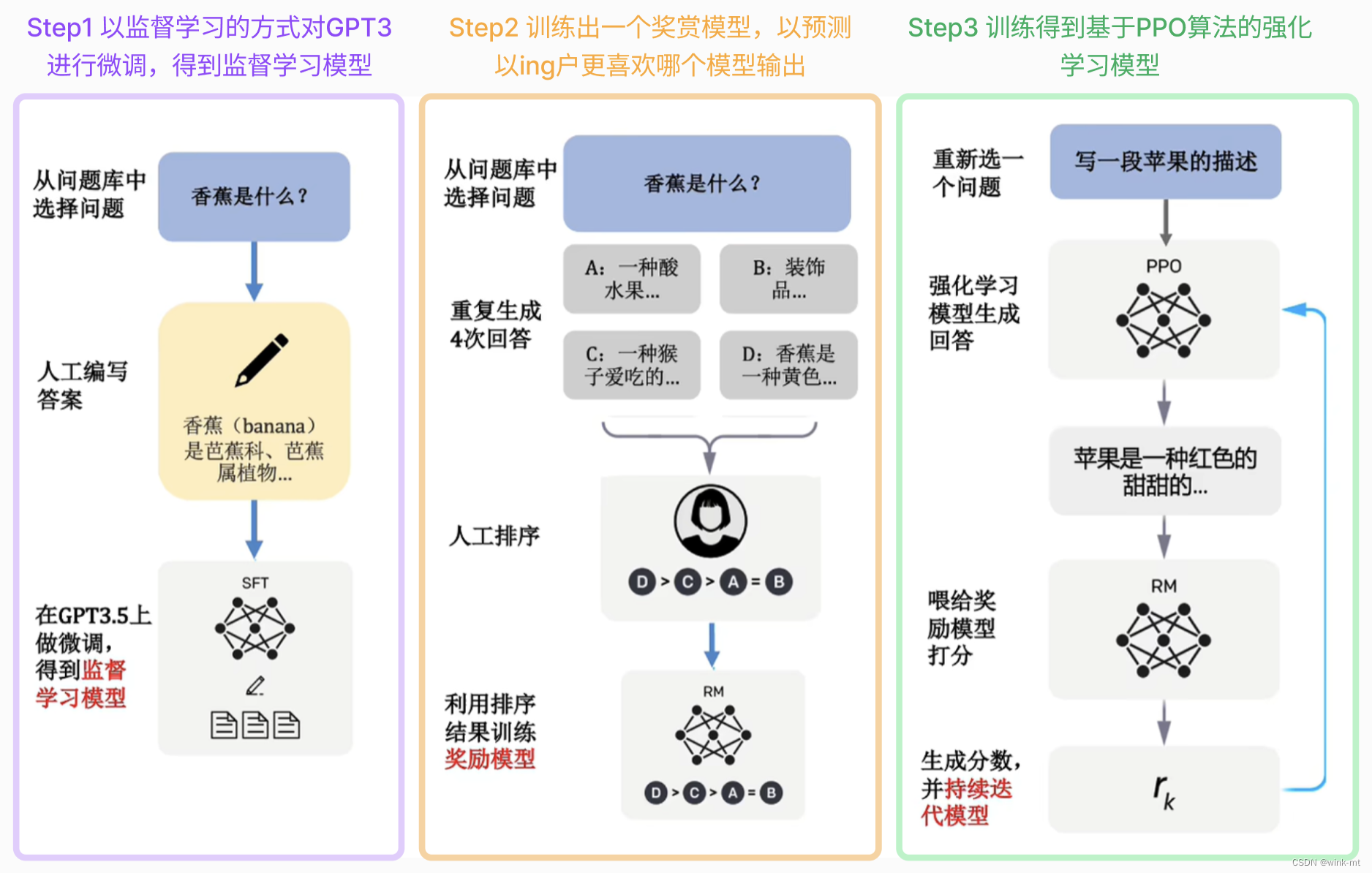

3.6人类反馈强化学习

模型的训练结果很大程度依赖人类的反馈,人类对其生成的结果进行打分将打分的结果重新输入的模型中,来对模型进行调整。

得分高相当于告诉它:“多生成这样的结果!”。得分低的相当于告诉它:“不要生成这样的结果!” ChatGPT=GPT+人类反馈强化学习

3.7ChatGPT训练步骤

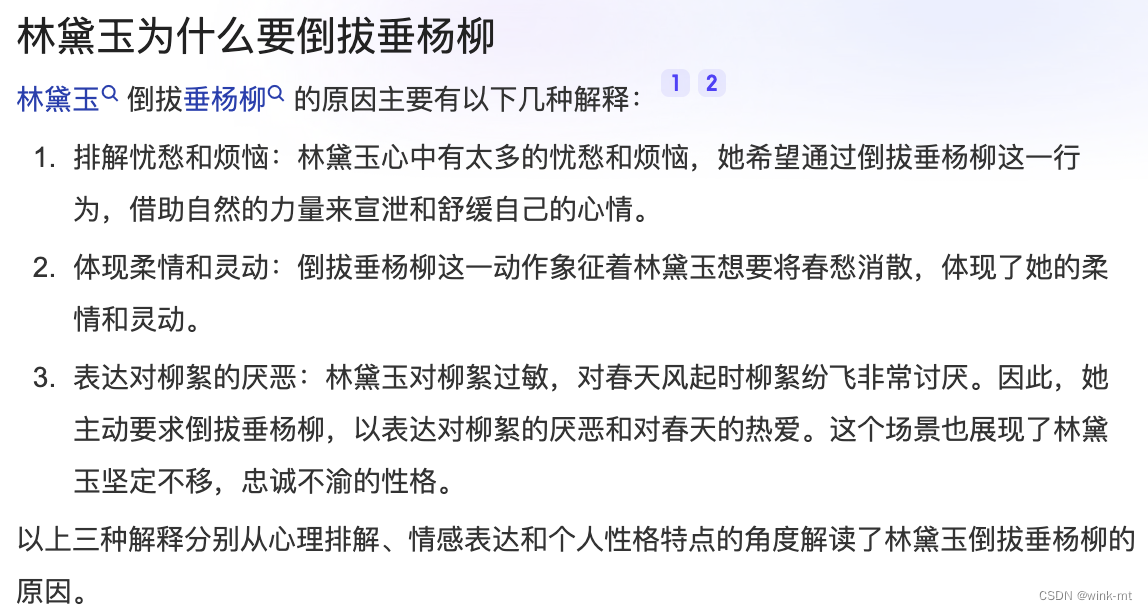

四、 幻觉

大语言模型只是根据上下文的信息去推演下一个字生成的概率,实际上并没有真正的理解能力,因此会输出一些“看似非常有道理,实则完全不对”的内容,这就是大模型的“幻觉”现象,即产生与某些来源无关的荒谬或不真实的内容,但这些内容从语义和语法层面来说却是符合逻辑的,但是不符合常识,简而言之就是“一本正经的胡说八道”。

4.1幻觉是怎么出现的?

1、数据不完备:受到人类要求的“逼迫”和具备的信息不匹配,导致它无从下手,只能按照预训练阶段所学到的概率一字一字往下编。想到小时候写作文时头痛,就是因为知识储备量不足,但是还得完成任务,只能保证语句通顺的情况下编凑。

2、信息描述不够准确:多义字、表述不准确等等。比如问你觉得苹果怎么样,在不同场景下的对答是不同的,比如在果园,比如上文在讨论的是手机,那么在限定背景下才能给出想要的答案。

3、对话策略缺陷:模型内部没有自己的决策体系,我们绝大多数情况都是一味地灌输知识,却没有告诉它不会的内容可以拒绝回答。模型甚至不知道自己不知道,就一个字一个字的吐了出来。

4.2如何缓解幻觉?

模型层面:

一个是从原始说一句入手,让模型学更多且正确的数据(比如让模型实时的爬取网页的信息,读取行业或有企业的一些私有信息,模型懂得越多,造假的概率就越小。现在有很多tob的公司都在做企业知识库,通过企业知识库的方式来减少大模型的幻觉。);

二是微调,可以以原始大模型为基础,将某一特定领域的高质量数据输入模型进行二次微调。(但是这里需求注意的是微调后的模型,很有可能会丧失原始大模型的部分能力,比如会丧失连续对话的能力,在企业知识库微调后尤为显著,会丧失60~70%的连续输出)

Prompt:

通过提示词为模型增加背景知识,通过限定回答字数、提供清晰精准的指令,或者引导模型从特定角度仔细思考来实现约束。(比如前面提到你觉得苹果怎么样,就可以给prompt加限定条件,你觉得苹果15怎么样)

专属知识库:要求模型只能从指定数据库中获取回答。以可信可靠的数据和知识,提高大模型输出的准确率。(如果知识库里没有搜到答案,那么输出兜底的话术就可以了)

五、涌现

5.1涌现——大模型的进化与失控

在人工智能领域,特别是大型语言模型(如GPT-3、ChatGPT等)的背景下,“涌现”(emergence)是指在大规模模型的训练过程中,模型表现出一些超出单个组件或模块功能的新特性或行为。这些新特性或行为通常是由模型内部的复杂交互和相互作用产生的,而不是由模型设计者直接编程的结果。

"涌现"可以理解为一个系统或过程在发展到一定阶段后,突然展现出新的特性或行为,这些特性或行为是之前没有预料到的,而且通常比单独的组成部分要复杂和有组织得多。在日常生活中也有一些涌现现象,比如雪花的形成、堵车、动物迁徙、涡流形成等。这里以雪花为例来解释:雪花的构成是水分子,水分子很小,但是大量的水分子如果在外界温度条件变化的前提下相互作用,在宏观层面就会形成一个很规律、很对称、很美丽的雪花。

当涌现出现时,会造成一个很尴尬的问题,人类创造了有思考能力的人工智能(进化),却不知道人工智能如何思考的(失控)。这也就是人们说的人工智能问题。

5.2涌现带来了哪些能力?

对于大型语言模型,可以直接去掉检索器,仅依赖模型的内部知识,且无需精调。

5.2.1涌现能力一

5.2.2涌现能力二

对人工智能最大的误解之一

短期的高估,长期的低估。

TPU(Tensor Processing Unit)是一种专门为深度学习计算设计的专用集成电路(ASIC)。它由谷歌设计,用于加速和优化 TensorFlow

等深度学习框架中的计算任务。TPU 针对矩阵乘法和卷积操作进行了优化,这些操作是深度神经网络中最常见和计算密集型的部分。 ↩︎