- 1解决Nginx同服务器下未配置SSL站点访问默认站点的问题_nginx中通一个server配置不含ssl的

- 2FastAPI到底用不用async?_fastapi async

- 3CloudNative:云原生(分布式云)的简介(发展&演变/为什么需要/优势&价值/安全/对比传统企业应用)、四大核心技术、CNCF云原生交互景观、云原生技术的使用经验及方法之详细攻略_cloud native

- 41.2懒汉模式及其问题、静态内部类实现单例模式_package singleton;public class lazysingletonprivat

- 5Unity2019 打包Android报错 Android NDK not found_unityexception: android sdk not found

- 6软件测试-环境搭建思路/测试流程_测试环境搭建流程】

- 7Vue Element Ui 树形表懒加载,操作数据更新_element 树形结构 表格不能刷新

- 8三级网站页面(网站中一级、二级、三级网站页面指的分别是什么)_三级页面

- 9医学图像——医学坐标体系_the axial plane the sagittal plane the coronal pla

- 10微信小程序从入坑到放弃二十五:记一次在WXS中使用正则表达式的坑_微信小程序 getregexp

一文带你了解【深度学习】中CNN、RNN、LSTM、DBN等神经网络(图文解释 包括各种激活函数)_cnn rnn lstm

赞

踩

觉得有帮助请点赞关注收藏~~~

一、深度学习概述

深度学习算法属于机器学习算法的范畴,深度学习一般具有自主学习能力

基于深度学习的自然语言处理基本操作步骤包括:

将原始信息输入神经网络模型,通过自主学习算法识别输入特征;

将特征作为深度神经网络输入;

根据不同需求选用合适的学习模型;

通过训练得出的模型预测未知场景。

神经元模型

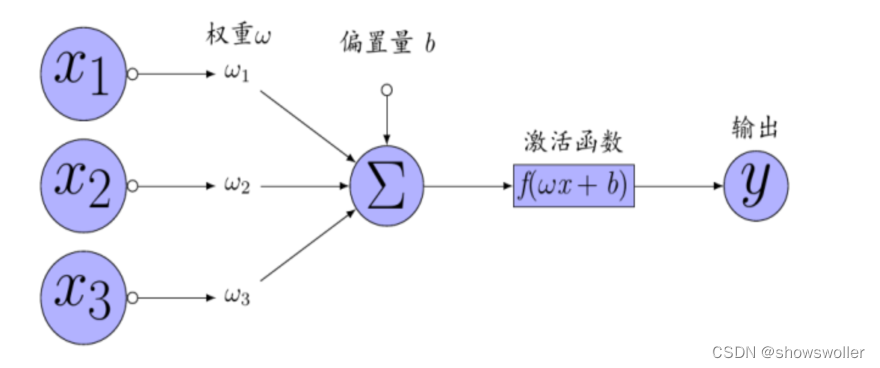

深度学习涉及神经网络的概念,其中最基本的神经元模型,可以使用下图表示,主要由输入变量 权重参数 偏置量 激活函数等组成

激活函数

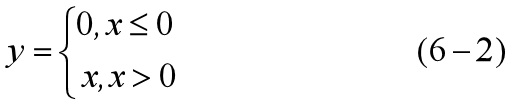

激活函数用于特征表达,常用的激活函数包括线性整流函数(Rectified Linear Unit, ReLU) 、Sigmoid函数和双曲正切函数(hyperbolic tangent,tanh)。

ReLU函数:

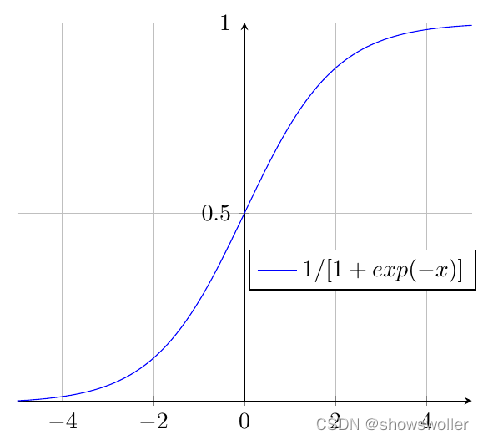

Sigmoid函数:

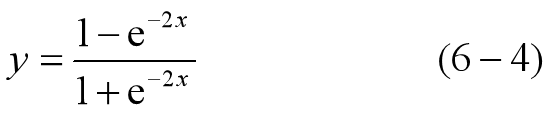

双曲正切函数:

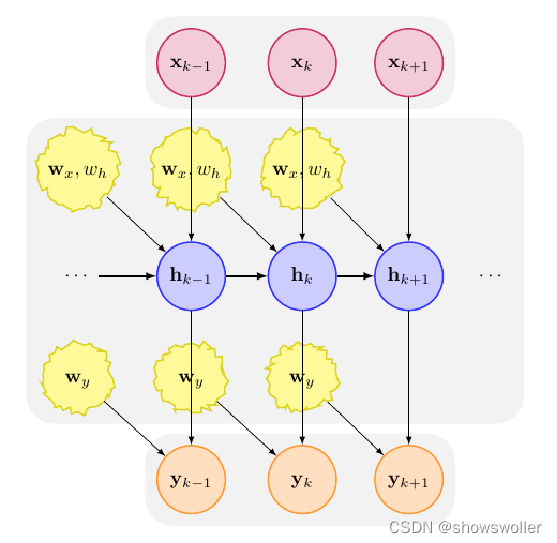

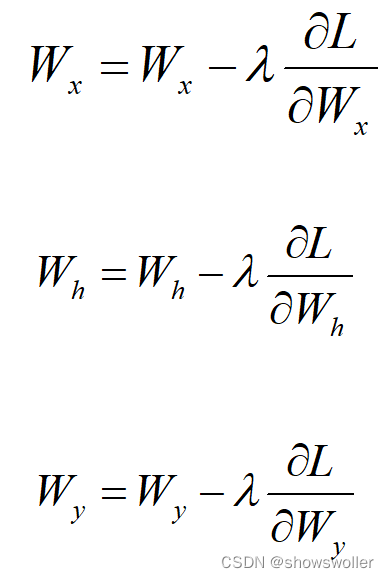

梯度下降法

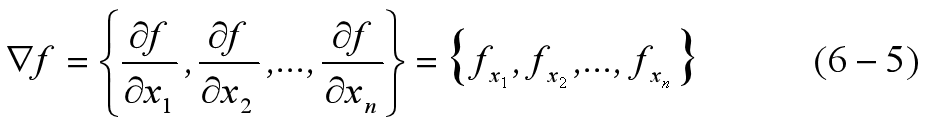

梯度表示函数在特定点的方向导数沿着该方向的最大值,即函数在特定点沿着该方向变化率最大。假定n元函数在n维空间具有一阶连续偏导数,函数在该空间上的任意点的偏导数或者梯度的数学表达式为:

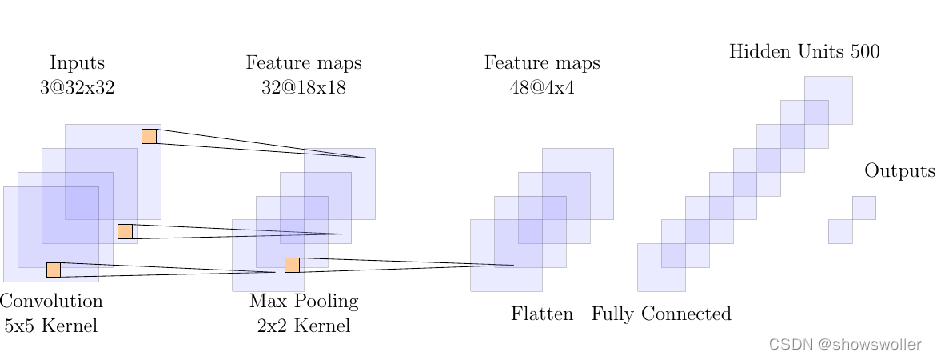

二、卷积神经网络CNN

卷积神经网络(Convolutional Neural Network,CNN)是包含卷积运算且具有深度结构的前馈神经网络(Feedforward Neural Networks)。具有表征学习(representation learning)能力,能够按其阶层结构对输入信息进行平移不变分类(shift-invariant classification),在计算机视觉和自然语言处理等领域得到了成功的应用。

卷积神经网络一般包含输入层(Input Layer)、卷积层(convolutional layer)、池化层(pooling layer)、全连接层(fully-connected layer)和输出层(Output layer)。

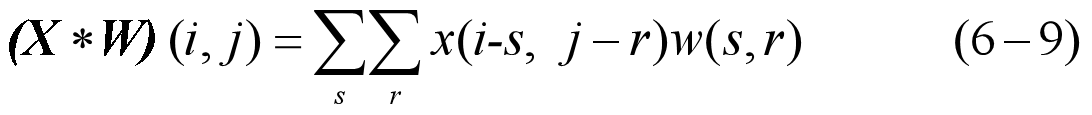

权重W也称为卷积核,卷积运算的主要目的是提取主要特征,去除噪音信号,选择不同的卷积核进行卷积运算,可以得到不同的特征信息。卷积操作原理可以参考图6-6,假定输入X的维度为7x7,选择卷积核W的维度为3x3,卷积核W在X平面上从左向右,从上往下依次移动,每次移动步长为1,则可以得出重合部分卷积结果的维度应为5x5,将卷积核W各位置的元素值与输入X对应位置的元素值相乘后求和,可以得出X*W对应位置的元素值,经过卷积处理后可以提取原输入的主要特征并实现降低维度的目的。

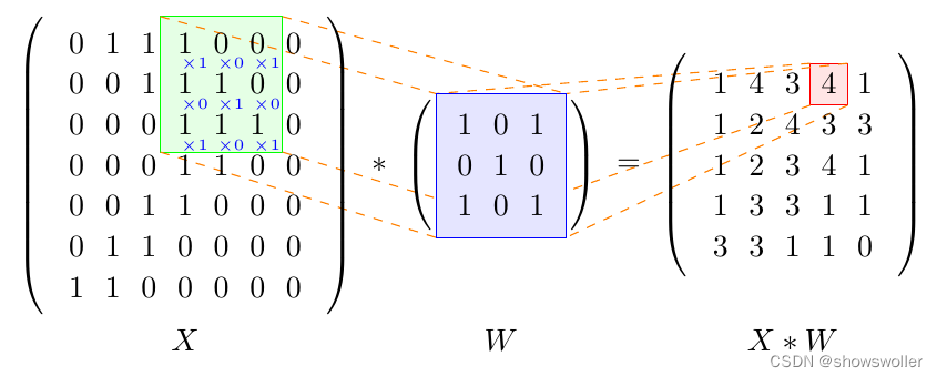

均值池化(average pooling)和极大池化(maximum pooling),

三、循环神经网络RNN

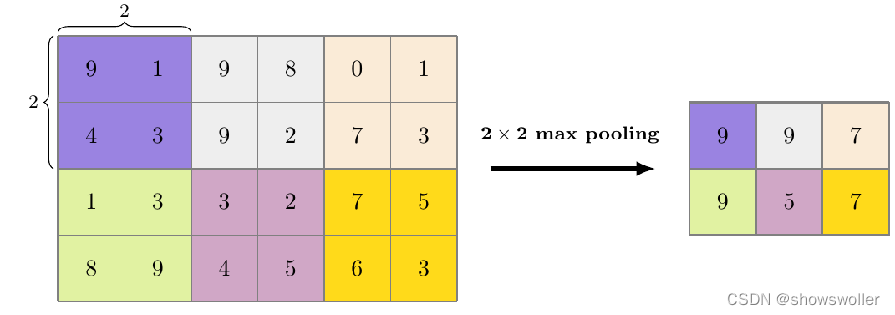

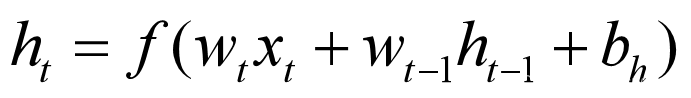

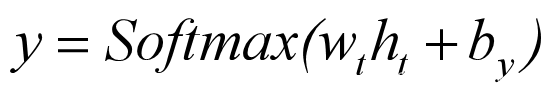

循环神经网络(Recurrent Neural Network,RNN)是以序列数据为输入,在序列的演进方向进行递归且所有节点(循环单元)按链式连接的递归神经网络(recursive neural network)。

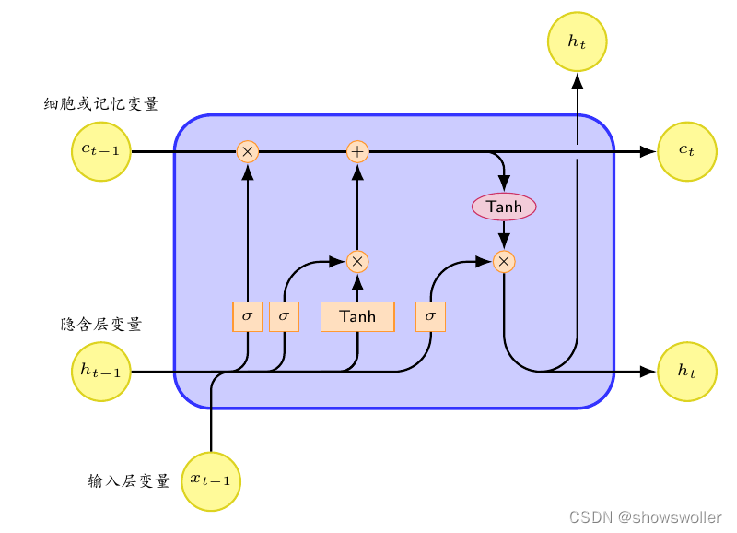

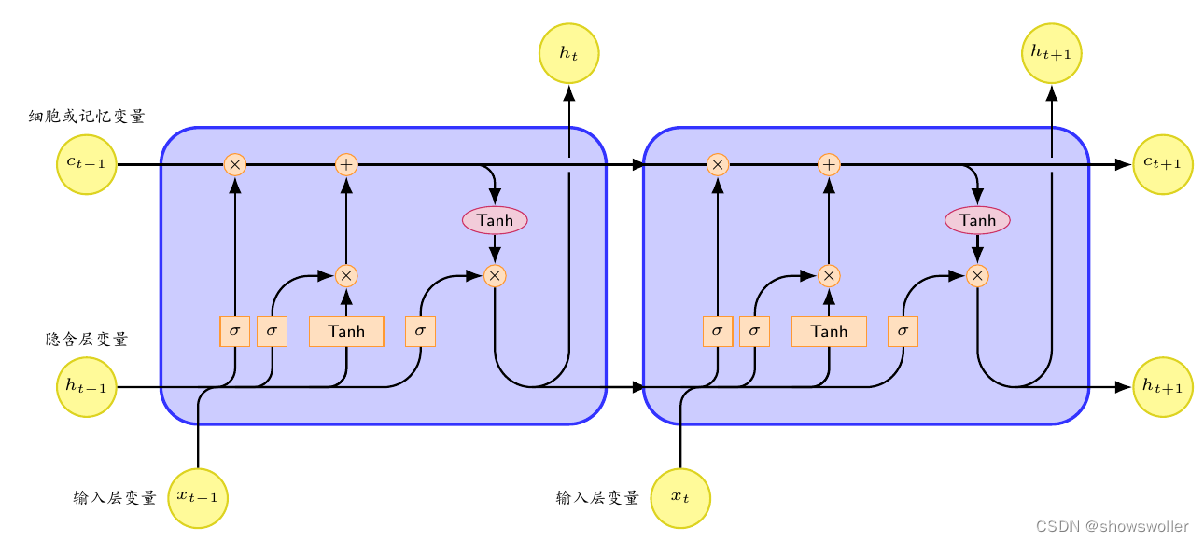

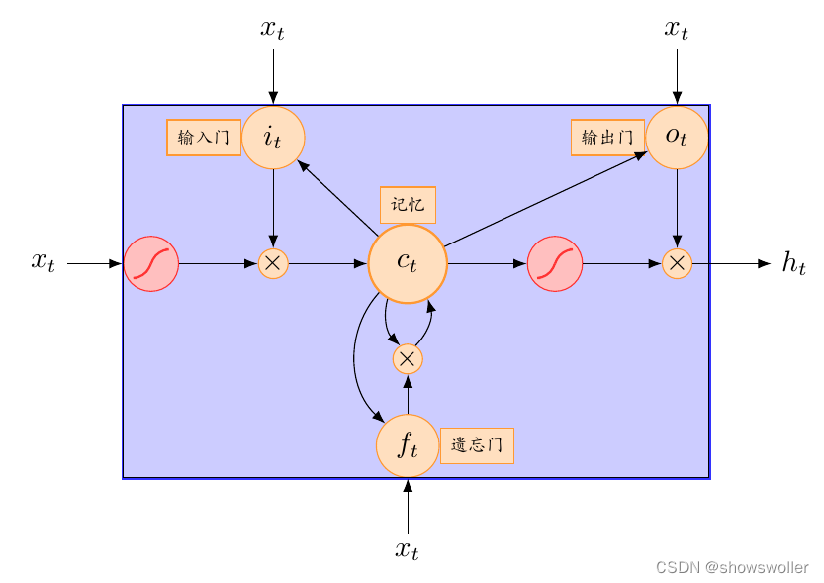

四、长短时记忆网络LSTM

长短时记忆网络(Long Short Term Memory Network:LSTM)可以存储状态信息,记忆不定时间长度的信息。区块中存在门能够决定输入信息是否重要到能被记住及能不能被输出,忘记门的原理类似,如果信息在这里输出结果趋近于零,则此处值将被忽略,不会进到下一层进行进一步处理。

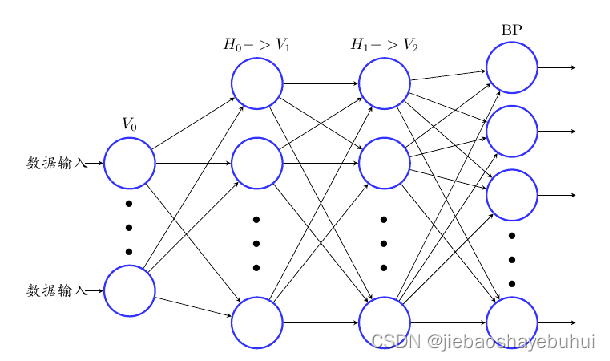

五、深度信念网络DBN

深度信念网络 (Deep Belief Network, DBN) 是一种生成模型,通过训练神经元间的权重,可以实现让神经网络按照最大概率来生成训练数据。可以使用 DBN 识别特征、分类数据和生成数据。

DBN由多层神经元构成,神经元分为显性神经元和隐性神经元。前者接收信息输入,后者提取特征。

创作不易 觉得有帮助请点赞关注收藏~~~