热门标签

热门文章

- 1python threading模块进阶之join_python threading join

- 2动手学CV-目标检测入门教程2:VOC数据集_voc格式数据集中的绝对路径信息

- 3为什么要用傅里叶变换?FFT你不知道的细节_fft算法的基本原理

- 4一、NLP中的文本分类_nlp文本分类

- 5苹果笔记本能玩网页游戏吗 苹果电脑玩steam游戏怎么样 苹果手机可以玩游戏吗 mac电脑安装windows

- 6深度学习-第J9周:Inception v3算法实战与解析

- 7利用AI Agent革新Text2SQL应用_chain of thought微调text2sql方法

- 8Elasticsearch:不用高深的数学知识来理解 LLMs 是如何工作的

- 9SFT 监督微调_sft微调任务

- 10YOLO目标检测综述(2024.6月最新!)_目标检测 综述

当前位置: article > 正文

使用 Swift 为您的 Mac 构建本地 LLAMA 3 应用程序(教程含源码)_ollama m3pro

作者:码创造者 | 2024-07-04 05:21:25

赞

踩

ollama m3pro

最近,Meta 发布了 LLAMA 3 并允许大众使用它(使其开源)。

为了测试配备精美 M3 Pro 芯片的新款 MacBook Pro 在设备语言模型上的处理速度,我决定下载该模型并制作一个 Mac 应用程序,以便随时从菜单栏与模型聊天。在这篇文章中,我将教你,是的,你,如何在 Mac 上本地部署你自己的语言模型。

设置 Ollama/部署本地模型

这部分比较简单。谢谢 Ollama 开发者!

第一步,访问ollama.com并按照其下载和设置说明进行操作。

也就是说,您将下载 Ollama 应用程序,打开它后,您将经历一个将 Ollama 安装到您的 Mac 上的设置过程。

安装 Ollama 后,我们可以下载并运行我们的模型。在本文中,我们将使用LLAMA3:8b,因为这是我的 M3 Pro 32GB 内存 Mac Book Pro 运行效果最好的。

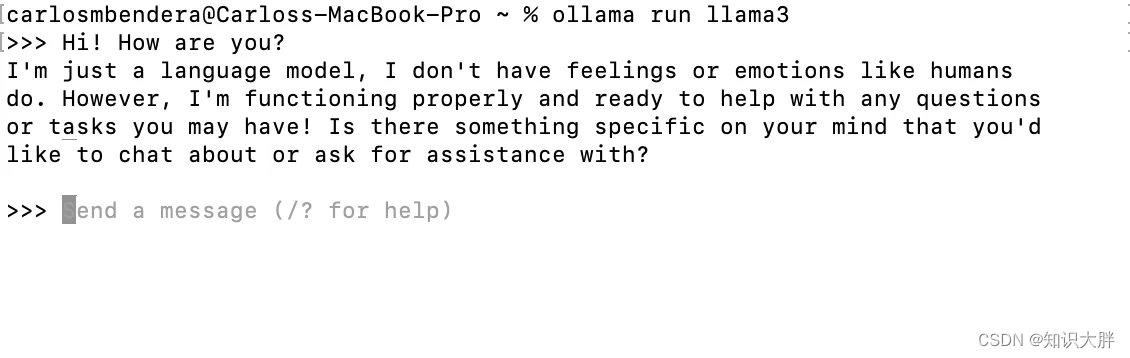

为此,我们将打开终端并 输入

ollama run llama3

- 1

这将下载模型并启动文本界面,您可以在其中通过终端与模型进行交互。

由于我之前运行过此命令,因此使用此命令只是启动模型,而不会导致它再次下载。

您可以使用以下命令退出该

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/码创造者/article/detail/785765

推荐阅读

相关标签